Saya lagi baca2 tentang metode ensemble learning. Ensemble learning melakukan kombinasi beberapa algoritma learning untuk meningkatkan performa. Ada dua metode yang populer di model ensemble, yaitu bagging dan boosting.

Bagging

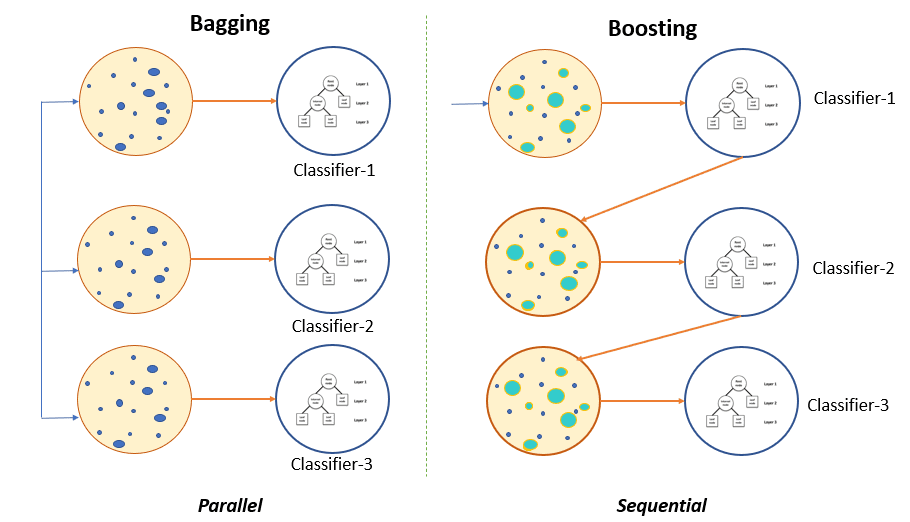

Bagging atau bootstrap aggregation adalah metode ensemble yang melakukan training beberapa classifier secara terpisah (paralel). Hasil dari training klasifier2 ini kemudian dikombinasi untuk menghasilkan prediksi akhir dari sistem.

Bagging diajukan oleh Breiman pada tahun 1994. Ketika kita melakukan training sebuah mode, hasil prediksi dan parameter modelnya tergantung pada ukuran data dan komposisi data yang digunakan pada training. Pada beberapa training bisa terjadi overfitting, dimana hasil prediksi dan model akhir berbeda jauh. Pada kasus ini, parameter model variance dan prediksi berbeda jauh. Dengan teknik bagging ini dapat digunakan untuk mengurangi model variance dan membuat prediksi lebih independen terhadap noise.

Model bagging yang populer diantaranya adalah random forest. Random forest adalah tipe khusus dari decision tree ensemble. Metrik yang digunakan untuk memprediksi eror dari random forest adalah out-of-bag error (OOB). OOB adalah rata-rata eror prediksi yang dihitung ddari semua sampel

Boosting

Bossting menggunakan beberapa model secara sequensial untuk meningkatkan performa. Beberapa weak model disusun untuk meningkatkan hasil prediksi. Weak Model yang dimaksud adalah model dengan parameter yang sedikit dan ditraining hanya dengan beberapa iterasi, contohnya shallow decision tree. Model lemah ini umumnya hanya menghasilkan performa yang baik pada data tertentu saja. Dengan boosting ditambahkan model lemah lainnya dengan tujuan pada eror dari model sebelumnya.

Kelebihan metode ini adalah memori. Model yang ditraining secara sequensial membutuhkan memori yang lebih sedikit, dibandingkan random forest yang melakukan training beberapa strong model secara bersamaan.

Keuntungan lainnya adalah spesialisasi pada weak model. Model2 ini secara umum tidak menghasilkan performa yang baik. Namun menghasilkan performa yang baik pada beberapa tipe data. Setiap model dapat di susun weight nya pada proses decision.

Boosting digunakan pada task prediksi numerik. Bisa juga digunakan untuk melakukan klasifikasi probabilitas kelas sebagai nilai prediksi. Training diakhiri ketika jumlah iterasi maksimal telah dicapai atau eror model terlalu besar. Boosting umumnya digunakan pada weak model. Teknik boosting cukup sensitif terhadap noise dan outlier, yaitu overfitting.

Gradient boosted trees adalah model ensemble yang menggabungkan beberapa model regression trees menjadi model yang kuat.

referensi:

https://www.pluralsight.com/guides/ensemble-methods:-bagging-versus-boosting