-

Study in Japan Fair

Ada titipan dari bu mia tentang acara study in Japan Fair. Acaranya online, Waktunya tanggal : 26-28 Januari 2024. Jadwal presentasi Kumamoto University : Jumat 26 Januari Jam 13.00 – 14.00 WIBAcaranya gratisRegistrasi sudah dibuka, silahkan kunjungi link berikut: https://www.okayama-u.ac.jp/user/asean/2024.html Info lebih lanjut bisa dilihat disini: https://ewww.kumamoto-u.ac.jp/sp/en/news/644/

-

Teknologi Terkini Generative AI – 2023

Saya baru baca tulisan di AItidbids tentang state-of-the art di bidang generative AI. State-of-the-art itu bisa diartikan sebagai teknologi terkini, atau yang paling unggul. Jadi Aitidbits ini membuat daftar teknologi terkini di bidang generative AI tahun 2023, kayak semacam kaleidoskop. Model bahasa (language model) Model open source: Yi: https://github.com/01-ai/Yi Mistral: https://mistral.ai Llama2: https://ai.meta.com/llama/ Code lama:…

-

Kuliah AI-Big Data – Latihan

a) training, b) validasi, c) testing dan d) implementasi di dunia nyata. Setiap tahapan memiliki strategi optimasi performa yang berbeda. Jelaskan langkah apa saja yang dapat dilakukan untuk meningkatkan performa pada setiap tahapan? 4. Jelaskan evaluation metrik apa saja yang dapat kita gunakan untuk menguji performa model machine learning! 5. Jelaskan bagaimana hubungan antara bias,…

-

Guest Lecture ITS

Rabu kemaren saya diminta mas Hatma senpai buat ngasih guest lecture kuliah manajemen insiden keamanan siber. Kuliahnya tentang pengenalan malware. Seru juga, ada banyak pertanyaan, diantaranya ada yang nanya tentang antivirus, tentang anaisa statik dll. Slidenya bisa dilihat disini Semoga bermanfaat!

-

Misumi West Port

Akhir tahun lalu saya dapat kesempatan ikut trip ke Misumi West Port. Misumi West Port ini terdaftar sebagai World Cultural Heritage Sites sebagai salah satu tempat bersejarah di Jepang pada era Revolusi Industri Meiji. Restorasi Meiji tercatat sebagai era kebangkitannya Jepang. Sebelumnya mereka menutup diri terhadap negara luar, semenjak era Meiji mereka membuka diri, bahkan…

-

Noh Theater – theater tradisional Jepang

Awal tahun ini disini ada kelas perkenalan tentang Noh theater, theater tradisional Jepang. Konon ada 3 jenis theater tradisional Jepang, Noh, Bunraku dan Kabuki. Noh ini yang maen cowok semua trus pake topeng, terus isinya lebih kayak cerita, misalnya tentang samurai. Sejarah Noh ini awalnya dari Cina pada jaman 6 masehi ada kesenian gagaku dan…

-

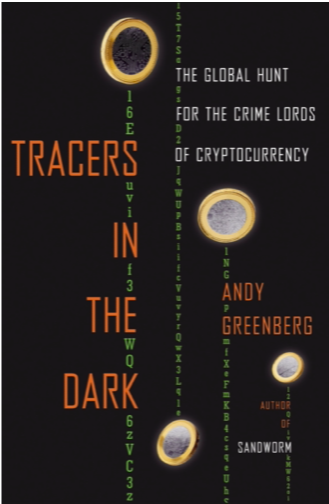

Tracers In The Dark – Andy Greenberg

Saya baru beres baca buku Tracers In The Dark – karya Andy Greenberg. Buku ini seru banget, bercerita tentang berbagai kasus kejahatan di dunia cryptocurrency dan bagaimana polisi menyelesaikan kasus2 tersebut. Andy Greenberg sendiri adalah jurnalis security dari majalah Wired. Baca buku ini kayak baca novel thriller yang menegangkan. Andy disini cerita tentang dunia gelap…

-

Science Research Writing

Semester ini saya dapet kuliah English for Science, isinya tentang penulisan karya ilmiah dan teknik presentasi. Yang ngajar Kishida Sensei. Buku referensinya “Science Research writing for non native speakers of english” oleh Hilary Glasman-Deal. Menurut saya cukup bagus buku ini. Dari buku ini diajarin penulisan paper jurnal yang sangat terstruktur. Pertama kita diajarin tentang tenses,…

-

Lebaran di Kumamoto

Alhamdulillah tahun ini saya menjalani puasa ramadan dan lebaran di Kumamoto. Walaupun muslim disini minoritas, tapi lumayan seru juga. Ada banyak kegiatan yang diadakan masjid disini. Menurut para sesepuh di kumamoto, tahun ini untuk pertama kalinya mesjid buka aktifitas ramadhan lagi. 2 Ramadhan sebelumnya karena Covid jadi gak banyak aktifitas selama ramadhan. Waktu itu katanya…

-

Noyaki trip di Gunung Aso

Minggu lalu saya mengikuti Noyaki Trip di Gunung Aso. Gunung Aso itu gunung berapi yang masih aktif, lokasinya gak jauh dari kumamoto. Disana ada grassland, alias padang rumput yang cantik. Akhir Februari ada tradisin warga disini buat ngebakar rumput disana yang disebut Noyaki 野焼き. Tradisi bakar rumput ini konon untuk tetap melestarikan padang rumput disini,…